Services Supplémentaires

Étude de cas

Nouvelles solutions de création de contenu par l'IA pour un géant des accessoires et vêtements de sport

- RESSOURCES

Pôles de connaissances Lionbridge

- Surmontez les limitations des LLM

- Résultats positifs pour les patients

SÉLECTIONNER LA LANGUE :

Quel est l'avenir de la traduction automatique (TA) ? C'est une question à laquelle nous réfléchissons jour après jour chez Lionbridge.

Les principaux moteurs de traduction automatique (Google NMT, Bing NMT, Amazon, DeepL et Yandex) ont peu, voire pas du tout, progressé en termes de qualité en 2022. Voyez par vous-même en consultant notre Machine Translation Tracker, le système de suivi de la TA le plus ancien du secteur. Ces résultats médiocres nous ont amenés à nous interroger sur le paradigme actuel de la traduction automatique neuronale (NMT – Neural Machine Translation).

- Le paradigme NMT a-t-il atteint un plateau ?

- Un nouveau changement de paradigme est-il nécessaire, compte tenu de l'incapacité des moteurs à démontrer des progrès significatifs ?

- Quelle pourrait être la prochaine étape ?

Nous parions que les grands modèles de langage (LLM), avec leurs quantités considérables de contenu, y compris la multimodalité et le multilinguisme, vont peser dans ce futur paradigme. Qu'est-ce qui nous amène à penser cela ? Ce sont les résultats de notre analyse révolutionnaire sur les performances de traduction de ChatGPT en comparaison avec celles des moteurs de TA.

ChatGPT, la dernière version de la famille de LLM GPT-3 d'OpenAI, a produit des résultats inférieurs à ceux des moteurs de TA désignés, mais pas de beaucoup. Ses performances ont été tout simplement remarquables et vont sans aucun doute retentir sur l'avenir de la traduction automatique.

Assiste-t-on à l'émergence d'un nouveau paradigme de la traduction automatique ?

Les tendances actuelles des moteurs de TA nous donnent une impression de déjà-vu.

Depuis la fin de l'ère de la traduction automatique statistique, que la NMT est venue remplacer, il n'y a eu pratiquement aucune variation dans la qualité de production de la TA. De plus, la qualité des résultats des différents moteurs de TA a convergé. Tout cela se passe actuellement.

Le remplacement de la NMT n'est peut-être pas imminent. Toutefois, si l'on se fie aux théories sur la croissance exponentielle et l'accélération des rendements, si l'on considère le développement de la TA basée sur les règles sur 30 ans, la proéminence de la TA statistique depuis 10 ans et le fait que la NMT a maintenant entamé sa sixième année, un nouveau changement de paradigme n'est peut-être pas si loin.

Quel pourrait être le prochain paradigme de la traduction automatique ?

Les progrès majeurs des LLM en 2022 ont ouvert la voie à cette technologie dans le domaine de la TA en 2023.

Les LLM sont des modèles génériques qui ont été entraînés à exécuter de nombreuses tâches. Cependant, nous avons vu certains LLM dédiés (ou affinés) réaliser des progrès essentiels dans certains domaines spécifiques avant même la fin de 2022. Ces développements ont préparé la technologie à effectuer des traductions moyennant un entraînement supplémentaire.

Par exemple, prenez ChatGPT. OpenAI a affiné ce dernier modèle dans le cadre de dialogues questions-réponses, tout en étant capable d'assurer les autres performances des LLM génériques.

Il pourrait se produire quelque chose de similaire pour la traduction, en affinant des LLM.

Comment les grands modèles de langage doivent-ils être affinés pour gérer la traduction ?

Les LLM seront probablement en mesure d'effectuer des traductions lorsque les machines auront été entraînées avec un corpus linguistique plus équilibré.

Le corpus d'entraînement de GPT-3 était à 93 % en anglais, tandis que seulement 7 % provenaient de corpus de toutes les autres langues. Si GPT-4, dont la sortie semble imminente, intègre davantage de corpus dans des langues autres que l'anglais, nous verrons peut-être des LLM plus à même de gérer le multilinguisme et, par conséquent, la traduction. En outre, ce corpus plus équilibré d'un point de vue linguistique peut servir de base à l'élaboration d'un modèle affiné spécialisé dans la traduction.

Un autre aspect intéressant de ce nouveau paradigme hypothétique de TA basée sur les LLM réside dans la tendance à la multimodalité. Nous pouvons entraîner des LLM à l'aide de données linguistiques et d'autres données, telles que des images et des vidéos. Ce type d'entraînement peut apporter des connaissances supplémentaires sur le monde en vue de meilleures traductions.

Les grands modèles de langage constitueront-ils une véritable alternative au paradigme de traduction automatique neuronale ?

Pour évaluer la susceptibilité des LLM à venir remplacer le paradigme NMT, nous avons comparé les performances de traduction de ChatGPT aux performances des cinq principaux moteurs de TA faisant l'objet de notre suivi régulier de la qualité de la TA.

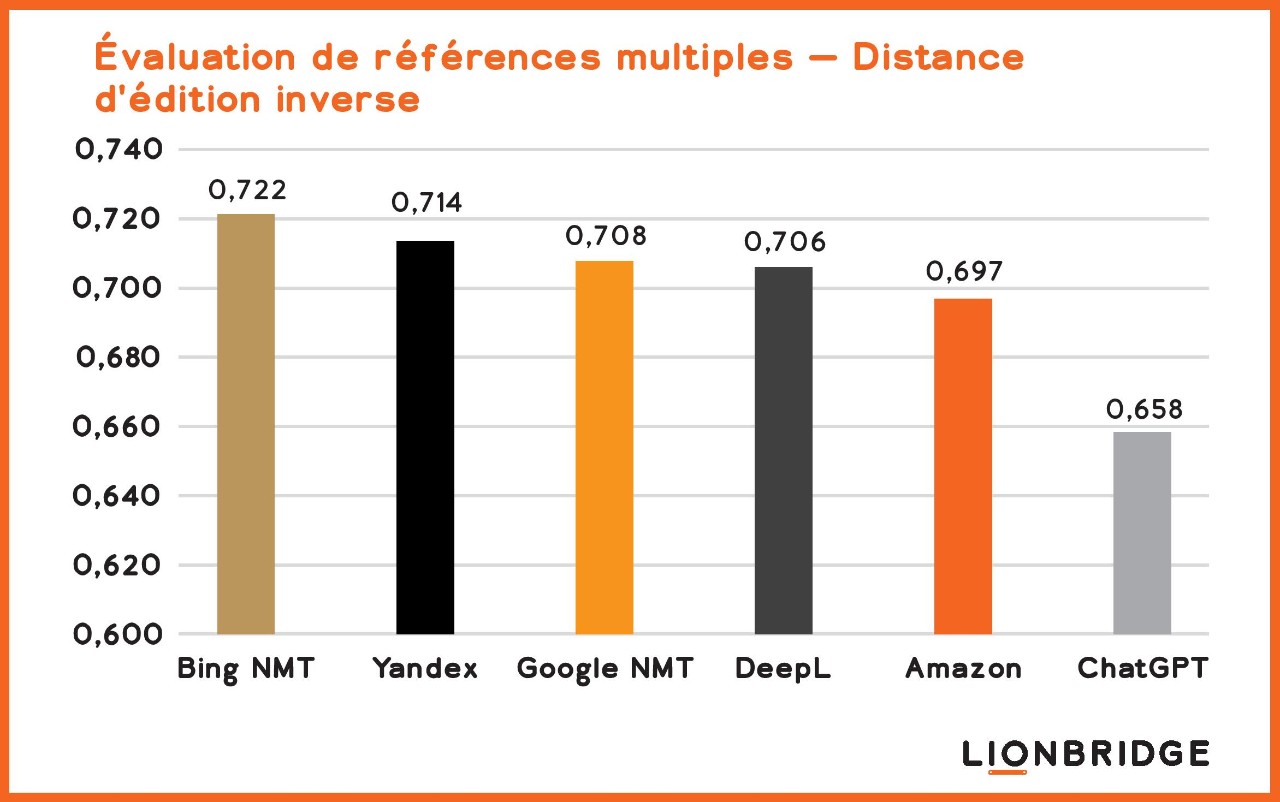

Comme on pouvait s'y attendre, les moteurs de NMT spécialisés traduisent mieux que ChatGPT. Mais étonnamment, les résultats de ChatGPT se sont révélés tout à fait respectables. Comme le montre la figure 1, ChatGPT a démontré des performances presque aussi bonnes que les moteurs spécialisés.

Comment avons-nous évalué la qualité de ChatGPT par rapport aux moteurs de TA génériques ?

Nous avons calculé le niveau de qualité des moteurs en fonction de la distance d'édition inverse, en utilisant plusieurs références pour la paire de langue anglais-espagnol. La distance d'édition mesure le nombre de modifications qu'un humain doit apporter au résultat de TA pour que la traduction générée soit aussi bonne qu'une traduction humaine. Pour notre calcul, nous avons comparé le résultat brut de la TA à 10 traductions humaines différentes (plusieurs références) au lieu d'une seule traduction humaine. La distance d'édition inverse signifie que plus le nombre résultant est élevé, plus la qualité est grande.

Figure 1. Comparaison de la qualité de la traduction automatique entre ChatGPT et les principaux moteurs de traduction automatique, basée sur la distance d'édition inverse à l'aide de plusieurs références pour la paire de langue anglais-espagnol.

Pourquoi les performances de traduction de ChatGTP sont-elles remarquables ?

Ces résultats de notre analyse comparative sont remarquables car le modèle générique a été entraîné à de nombreuses tâches différentes de traitement automatique du langage naturel (TALN), par opposition à la seule tâche de traduction de TALN à laquelle les moteurs de TA ont été entraînés. Et même si ChatGPT n'a pas été spécifiquement entraîné pour exécuter des traductions, ses performances en la matière se rapprochent du niveau de qualité que les moteurs de TA enregistraient il y a deux ou trois ans.

Lisez notre blog pour en savoir plus sur ChatGTP et la localisation.

Comment la traduction automatique pourrait-elle évoluer grâce aux grands modèles de langage ?

Compte tenu de la croissance des LLM (basée sur l'intérêt du public et les investissements importants des entreprises technologiques dans cette solution), nous pourrons bientôt voir si ChatGPT dépasse les moteurs de TA ou si la TA commencera à adopter un nouveau paradigme de LLM.

La TA peut utiliser les LLM comme fondement, puis affiner la technologie spécifiquement pour la traduction automatique. Le processus correspond à ce que font OpenAI et d'autres sociétés LLM pour améliorer leurs modèles génériques en fonction de cas d'utilisation spécifiques, tels que permettre aux machines de communiquer avec les humains de manière conversationnelle. La spécialisation ajoute de la précision aux tâches effectuées.

Quel est l'avenir des grands modèles de langage en général ?

L'avantage des modèles de langage « génériques » de grande taille est qu'ils peuvent faire beaucoup de choses différentes et offrent une qualité exceptionnelle dans la plupart de leurs tâches. Par exemple, GATO de DeepMind, un autre modèle d'intelligence générale, a été testé dans plus de 600 tâches, avec des résultats à la pointe de la technologie (SOTA – State-of-the-Art) pour 400 d'entre elles.

Deux lignes de développement continueront d'exister : des modèles génériques, tels que GPT, Megatron et GATO, et des modèles spécialisés à des fins précises basés sur ces modèles génériques.

Les modèles génériques sont importants pour faire progresser l'Intelligence générique artificielle (AGI) et, éventuellement, favoriser des développements encore plus impressionnants à plus long terme. Les modèles spécialisés auront des utilisations pratiques à court terme pour des domaines spécifiques. L'un des aspects remarquables à propos des LLM est que les deux lignes peuvent progresser et fonctionner en parallèle.

Quelles sont les implications d'un changement de paradigme en matière de traduction automatique ?

Alors que le paradigme actuel de la technologie de traduction automatique neuronale atteint ses limites et qu'un nouveau paradigme technologique dominant de traduction automatique émerge, probablement basé sur les LLM, nous nous attendons à divers changements dans le monde de la TA. La plupart de ces changements seront profitables aux entreprises. Toutefois, ils présenteront des défis supplémentaires pour les entreprises qui cherchent à exécuter des traductions humaines.

Nos prévisions :

Qualité améliorée

La qualité de la traduction automatique fera un bond en avant, à mesure que les progrès technologiques résoudront des problèmes identifiés de longue date, tels que la traduction automatique et le langage formel ou informel et d'autres problèmes de qualité liés au ton. Les LLM pourraient venir pallier le plus gros problème des moteurs de TA : leur manque de connaissance du monde. L'entraînement à la multimodalité pourrait en effet les conduire à cet aboutissement.

Les spécialistes en technologies entraînent les LLM modernes non seulement avec de grandes quantités de texte, mais aussi avec des images et des vidéos. Ce type d'entraînement permet aux LLM de relier leurs connaissances entre elles, ce qui aide les machines à interpréter le sens des textes.

Production accrue de contenu et intervention réduite de traducteurs experts

Les entreprises pourront créer davantage de contenu plus rapidement, de sorte que la quantité de contenu dépassera les capacités du pool de traducteurs. Même avec une traduction automatique améliorée et une productivité accrue des traducteurs, la communauté des traducteurs aura toujours du mal à satisfaire les demandes de traduction.

Adoption accrue de la traduction automatique

À mesure que le nouveau paradigme technologique sera disponible et que la qualité de la traduction automatique s'améliorera, la demande de services de traduction continuera d'augmenter, ce qui favorisera l'adoption dans un plus grand nombre de situations et de cas d'utilisation.

Recours à la traduction automatique pour améliorer l'expérience client

Avec une meilleure qualité de TA et le besoin d'expériences clients plus personnalisées et sur mesure, les entreprises auront plus fréquemment recours à la TA pour améliorer les expériences numériques de leurs clients mondiaux et consolider leurs relations.

Que faut-il en conclure ?

Les entreprises technologiques manifestent un immense intérêt envers la technologie des LLM. Microsoft investit 10 milliards de dollars dans OpenAI. Nvidia, Google et d'autres entreprises investissent également massivement dans la technologie des LLM et l'IA.

Nous sommes intrigués par ce que l'avenir nous réserve et continuerons d'évaluer les LLM. Consultez régulièrement cet espace afin de vous tenir informé à propos de cette évolution extrêmement intéressante.

Nous contacter

Si vous souhaitez savoir comment Lionbridge peut vous aider à tirer pleinement parti de la traduction automatique, contactez nous dès aujourd'hui.